AI 시대의 책임 있는 Azure AI 콘텐츠 거버넌스

올해 초 South Australia Department for Education는 생성 AI를 교실에 도입하기로 결정했습니다. 하지만 신기술 도입에 앞서 “AI 콘텐츠로부터 안전성이 책임감 있게 보장되는가?”와 같은 제언이 화두가 됐습니다. 그 우려의 핵심은 부적절하고 해로운 콘텐츠로부터 학생들을 잠재적으로 보호하는 것이었습니다. 대규모 언어 모델(LLM)의 출력은 필터링을 거치지 않은 방대한 양의 인터넷 자료에서 학습되기 때문입니다.

Digital Architecture 부서 담당자인 Simon Chapman은 “공개된 생성 AI에서 교육에 적용할 수 있는 부분은 극히 제한적입니다. 학생들이 어떻게 상호 작용할지에 대한 가이드라인이 없기 때문”이라고 말했습니다.

(사진_South Australia Department for Education 제공)

그럼에도 불구하고 Digital Architecture 부서는 마침내 Azure 기반 AI 챗봇의 시범 프로젝트를 마무리하고 있습니다. 8개의 중학교에서 거의 1,500명의 학생과 150명의 교사가 세포 분열에 대한 내용부터 존 스타인벡의 소설 ‘생쥐와 인간’의 줄거리 등 교육과 관련된 모든 것을 연구하는 데 도움이 되는 챗봇의 능력을 테스트했습니다. 이에 대한 가이드라인이 된 Microsoft 시스템은 조직이 더 안전한 온라인 환경을 만드는 데 도움이 되는 AI 기반 플랫폼인 ‘Azure AI Content Safety’에서 높은 점수를 받았습니다.

Simon Chapman은 Azure 기반의 AI 챗봇에 내장된 안전 기능이 부적절한 입력 쿼리를 차단하고 유해한 응답을 필터링해 교사가 콘텐츠 감독보다는 기술의 교육적 이점에 집중할 수 있다고 말했습니다.

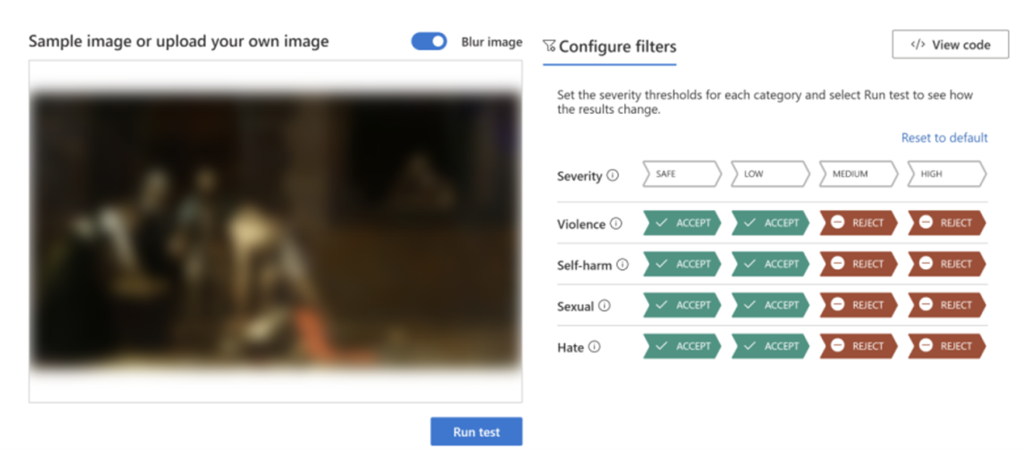

Microsoft가 개발한 Azure AI 플랫폼 내 ‘Azure AI Content Safety’를 통해 사용자가 증오, 폭력, 성적 및 자해 콘텐츠를 검토할 수 있도록 도움을 주고 있습니다. 고급 언어 및 비전 모델이 잠재적으로 유해한 콘텐츠를 감지하면 예상 심각도가 점수로 표시됩니다. 이를 통해 기업과 조직은 정책에 따라 콘텐츠를 차단하거나 플래그를 지정하도로 서비스를 조정할 수도 있습니다.

처음 ‘Azure AI Content Safety’가 개발될 때는 Azure OpenAI 서비스의 일부로 도입됐지만, 현재는 독립형 시스템으로 활용할 수 있습니다. 이는 고객이 오픈 소스 모델뿐만 아니라 다른 회사 모델에서 생성된 AI 콘텐츠를 사용자가 생성한 콘텐츠 시스템의 일부로 사용할 수 있다는 의미입니다. Microsoft는 이러한 콘텐츠 활용 프로세스를 통해 그 유용성을 확대할 수 있다고 제안하고 있습니다.

Microsoft의 부사장 Eric Boyd는 “생성 AI가 주류로 진입함에 따라 Microsoft는 생성 AI를 보다 안전하게 배포하는 데 필요한 도구를 기업에 제공하는 것을 목표로 합니다”고 말했습니다. “지금 우리는 현재 기업들이 생성 AI의 놀라운 능력을 지켜보고 있는 중요한 순간”이라며 Azure AI Content Safety를 독립적인 제품으로 출시한 것은 훨씬 더 광범위한 비즈니스 요구 사항을 가진 고객에게 더 포괄적인 서비스를 제공할 수 있음을 의미한다고 말했습니다.

이는 Microsoft가 AI를 책임감 있게 만들기 위한 원칙을 어떻게 실천해 오고 있는지를 보여주는 한 예시일 뿐입니다. 지난 몇 년 동안 Microsoft는 ‘책임 있는 AI(Responsible AI)’ 거버넌스를 옹호하고 있으며 미국 백악관의 ‘자발적인 AI 안전 서약’에 지지를 약속했습니다. 책임 있는 AI를 위해 제품 개발 정보를 제공하고, 책임 있는 AI 연구의 경계를 확장하고 있으며 AI 시스템 설계, 구축 및 테스트를 위한 표준을 발표했습니다. 이에 대한 일관된 행보로써 Azure Machine Learning의 책임 있는 AI 대시보드와 같은 도구를 고객에게 제공하고 있습니다.

Microsoft에서 책임 있는 AI를

이끌고 있는 제품 관리자 Sarah Bird는 “책임 있는

AI는 지금 와서 떠오르게 된 사항이 아니라, AI 혁신

스토리의 핵심입니다. 우리는 이러한 책임 있는 AI 문제를

해결하는 방법을 알아내기 위해 최고의 도구를 제공하고자 합니다”라며 “Azure

AI Content Safety는 생성 AI 어플리케이션을 더 많은 고객에게 제공할 수

있는 기반이 되었습니다”고 덧붙였습니다.

다양한 사용 사례에 맞게 사용자 맞춤 조정 가능

내부적으로 Microsoft는 자체 AI 기반 제품의 사용자를 보호하기 위해 Azure AI Content Safety에 의존해왔습니다. 이 기술은 빙(Bing), 깃허브 코파일럿(GitHub Copilot), 마이크로소프트 365 코파일럿(Microsoft 365 Copilot), 애저 머신러닝(Azure Machine Learning)과 같은 제품에서 채팅 기반 혁신을 책임 있게 출시하는 데 필수적이었다고 Microsoft는 말합니다.

콘텐츠가 넘쳐나는 세상에서 책임 있는 AI 문제는 비즈니스와 산업 전반에 걸쳐 있는 문제이기 때문에 Azure AI Content Safety의 주요 이점은 정책을 각 고객의 특정 환경 및 사용 사례에 맞게 조정할 수 있다는 유연한 구성 가능성입니다. 예를 들어, 게임에 초점을 맞춘 플랫폼은 폭력적인 언어에 대해 학교 교육과는 다른 기준을 설정할 가능성이 높습니다.

(사진_Microsoft 제공)

생성 AI 시대에서의 신뢰 구축

생성 AI가 계속 확산됨에 따라 온라인 공간에 대한 잠재적 위협도 증가할 것으로 예상됩니다.

Microsoft는 이러한 위협에 대비하기 위해 연구 및 고객 피드백을 통해 기술을 지속적으로 개선할 것이라고 Sarah Bird는 말했습니다. 예를 들어 멀티모달모델(LMM)에 대한 지속적인 작업은 개별 검사에서 놓칠 수 있는 잠재적으로 불쾌한 이미지와 텍스트의 조합(밈을 생각해 보세요)의 감지를 강화할 것입니다.

Sarah Bird는 Microsoft가 수십 년 동안 콘텐츠 조정을 처리해 Xbox 포럼에서 Bing에 이르기까지 모든 곳에서 사용자를 보호하는 데 도움이 되는 도구를 만들었다고 언급했습니다. Azure AI Content Safety는 이러한 환경과 고객이 콘텐츠 검색 기능을 활용할 수 있도록 지원한 이전 서비스인 Azure Content Moderator를 기반으로 하며 강력한 새 언어 및 비전 모델을 활용합니다.

Microsoft는 전반적인 안전에 대해 생각함으로써 고객이 신뢰할 수 있는 AI를 광범위하게 채택할 수 있기를 희망하고 있습니다. Eric Boyd는 “신뢰는 처음부터 Microsoft 브랜드와 Azure의 초석이었습니다. AI 시대로 접어들면서 우리는 고객을 보호하는 방법을 계속 확장하고 있습니다”고 말했습니다.

Related Posts

(주)클루커스

[본사] 서울특별시 강남구 논현로75길 6 (역삼동, 에비뉴75) | Tel.02-597-3400 | E-mail.marketing@cloocus.com

[지사] 부산광역시 해운대구 센텀중앙로 55, 13F (센텀산학캠퍼스) | Tel.051-900-3400

[United States] 500 7th Ave. Fl 8 New York, NY 10018 | Tel.+1 408.7722024 | E-mail.info_us@cloocus.com

[Malaysia] A-3A, Block A, Level 3A, Sunway PJ51A, Jalan SS9A/19, Seri Setia, 47300 Petaling Jaya. | Tel.+6016 331 5396 | E-mail.infoMY@cloocus.com

개인정보처리방침 서비스 이용약관 Privacy Update

Copyrights 2024 Cloocus co.,ltd. all rights reserved.